「また今日も手作業でサイトチェックか…」とため息をついていませんか?

競合調査や商品リスト作成など、情報収集は時間がかかるだけでなく、ミスも起こりやすいもの。

でも、今はスクレイピングツールを使えば、これらの作業を自動化できる時代です。

この記事では、現場担当者でも実用的に使える厳選3選を、わかりやすくご紹介します。

あなたにぴったりの方法がきっと見つかるはずです。ぜひ最後までご覧ください!

ただしスクレイピングのやり方によっては、法律に抵触してしまう恐れがあります。

スクレイピング対象のWebサイトの利用規約を守り、対象サイトに負荷をかけすぎないように行うようにしましょう。

当ブログがオススメする

業務自動化サービスランキング

| 1位:ジドウカ | 2位:Yoom | 3位:UiPath | |

|---|---|---|---|

| LP |  |  |  |

| 全体評価 | ★★★★★ | ★★★★☆ | ★★☆☆☆ |

| URL | https://data-x.jp/jidouka/lp/ | https://lp.yoom.fun/ | https://www.uipath.com/ja |

| 特徴 | ☑お客様自身で開発する必要がない自動化サービス。 ☑BPOのような感覚で自動化したい内容を依頼することが可能。 | ☑450種類以上のサービスとの連携が可能。 | ☑業務フローを視覚化し直感的に自動化が可能。 |

| 自動化技術の幅 | RPA/ Google Apps Script / VBA / 生成AI / ローコード・ノーコードツール | オリジナルサービス | RPA |

| ユーザーの開発負担 | ◎ お客様自身は 開発の必要なし | △ 自社で開発が必要 | △ 自社で開発が必要 |

| 自動化までのフロー | ◎ 自動化したい内容を 伝えて待つだけ。 | △ 自社で要件定義し 開発・運用 | △ 自社で要件定義し 開発・運用 |

| 費用 | ◎ 月額1万円〜 | ◎ 無料でスタート可能 | ☓ 52万5000円 |

| こんな方におすすめ | ・自動化したい内容が決まっている ・手離れよく自動化したい ・あまりコストをかけたくない | ・社内にエンジニアがいる ・自社でノウハウを貯めている ・開発・運用体制が整っている | ・RPAで自動化できるか業務が何か判断できる人材がいる企業 ・自社内にエンジニアがいる |

なお、業務効率化や工数削減を目指しているものの、どの業務から自動化すべきか、どのツールや手段が自社に合っているのかがあいまいな方は、「業務自動化プラン診断」をお試しください。

かかる時間は1分ほど。4つの質問に答えるだけで、あなたに最適な自動化対象業務や、推奨される自動化手段を診断してもらえます。

効率よく自社に適した業務効率化を知りたい方は、ぜひ一度お試しください。

\ 4つの質問に答えるだけ /

この記事で紹介するツールの比較まとめはこちら!

| ツール名 | 特徴 | こんな人におすすめ | 直感的な操作性 | 対応できるサイトの幅広さ | データ精度・安定性 | 保守・メンテナンス性 | コスパ |

| Octoparse | ノーコード操作、初心者向け、日本語対応 | 手軽に始めたい、まず試したい | ★★★★★ | ★★★☆☆ | ★★★☆☆ | ★★★☆☆ | ★★★★☆ |

| ParseHub | 高度な設定可能、動的ページ対応 | 本格的に収集したい、複雑なサイトを扱う | ★★★☆☆ | ★★★★★ | ★★★★☆ | ★★★☆☆ | ★★★☆☆ |

| Python(Requests+BeautifulSoup) | 自由度最強、完全カスタマイズ可 | 自社専用ツールを作りたい、エンジニアリソースがある | ★★☆☆☆ | ★★★★★ | ★★★★★ | ★★★☆☆ | ★★★★★ |

Web情報収集を自動化した方が良い理由

手作業の情報収集には、このような課題が潜んでいます。

・作業時間が無駄にかかる

本来やるべき業務(分析や提案)に時間を割けなくなります。

・ミスや抜け漏れが発生する

大量のコピペ作業は、どうしてもヒューマンエラーを招きます。

・リアルタイム性に欠ける

手作業だと更新タイミングが遅れ、鮮度の高い情報を逃してしまいます。。

これらの課題を解決するのが、自動取得ツールの導入です。

Octoparse(オクトパース)

| メリット | ノーコードで直感的に操作できるテンプレート機能がある日本語対応がある |

| デメリット | 複雑なサイトではエラーが出やすい 無料版には機能制限がある |

| こんな方におすすめ | スクレイピング初心者社内業務を効率化したい担当者 非エンジニアの方 |

| 評価(☆5段階) | 直感的な操作性:★★★★★ 対応できるサイトの幅広さ:★★★☆☆ データ精度・安定性:★★★☆☆ 保守・メンテナンス性:★★★☆☆ コストパフォーマンス:★★★★☆ |

実際に使ってみた感想

「こんなに簡単にできるんだ!」と驚きました。画面をクリックして指定するだけで、すぐにデータ収集が始められるのはとても直感的に使えます。

ただ、動的なサイトや変則的なレイアウトだと少し苦戦する場面もありました。

「まず一歩踏み出したい」「できるだけ簡単に自動化したい」という方にピッタリです。

サービスの概要・使い方・特徴を紹介

Octoparseは、Webサイト上の情報をプログラミング不要で収集できるスクレイピングツールです。

基本操作は対象データをクリックで選択して保存するだけなので、エンジニア経験がない人でも扱えます。

主な特徴は以下の通りです。

・ノーコードで作業できる

・一覧→詳細ページの遷移も自動対応

・クラウド上で実行可能(PCを閉じても動作)

・無料プランあり。月額数千円〜の有料版でより高速・高機能に。

具体的な設定手順(5ステップ)

- Octoparseをインストールして起動する

Octoparse公式サイト(https://www.octoparse.jp/ )にアクセスし、「ダウンロード」ボタンをクリックしてパソコンにインストールします。

インストール後、Octoparseアカウントを作成し、ログインします。

- 新しいタスクを作成し、対象URLを入力する

Octoparseのダッシュボード画面で「+カスタマイズタスク」をクリック。

- データを取得したいWebページのURL(例:https://www.amazon.co.jp/ )を入力し、「開始」を押します。

- 欲しいデータをクリックして選択する

Webページが画面内に表示されるので、取得したい項目(商品名、価格など)を実際にクリックします。

- 「実行」をクリックします。

- 収集方法を設定する

ローカル収集orクラウド収集の「通常モード」をクリックします。

実行中の画面が表示されます。

- 「エクスポート」データをエクスポートする

ParseHub(パースハブ)

| メリット | ログイン後サイトや複雑な動きにも対応、細かい設定が可能 |

| デメリット | 操作が直感的ではない、英語ベースのUI |

| こんな方におすすめ | 本格的にデータ収集をしたい方、カスタマイズ重視の方 |

| 評価(☆5段階) | 直感的な操作性:★★★☆☆ 対応できるサイトの幅広さ:★★★★★ データ精度・安定性:★★★★☆ 保守・メンテナンス性:★★★☆☆ コスパ:★★★☆☆ |

実際に使ってみた感想

細かいクリックやスクロール動作まで記録できるので、複雑なWebサイトでもしっかりデータを集められるのが魅力。

ただ、操作に少し慣れが必要で、最初は英語の設定画面に戸惑いました。

「最初から本格的な自動化に挑戦したい」という意欲的な方にはおすすめです!

サービスの概要・使い方・特徴を紹介

ParseHubは、動的サイトや複雑なページ構造でも対応できる高性能スクレイピングツールです。

主な特徴は以下の通りです。

・ドロップダウンメニューやポップアップも操作可能

・ログイン後ページにも対応

・クラウドベースでのデータ収集が可能

具体的な設定手順(5ステップ)

- ParseHubをインストールしてアカウント作成する

ParseHub公式サイト(https://www.parsehub.com/ )からアプリをダウンロードし、インストールします。

- アカウント登録(無料)を済ませ、ログインします。

- 「New Project」で取得したいWebサイトを開く

ParseHubを開き、[New Project]ボタンをクリック。

- 取得対象のWebサイトURLを入力して「Start project on this URL」を選びます。

- 対象データ(商品名や価格など)を選択・グループ化する

ページ上で収集したいデータ(例:商品名)を1つクリックします。

- もう1つ商品を選択すると、同じ種類のデータがまとめて選択されます。

- プロジェクトを実行してデータをエクスポートする

「Get Data」→「Run」でスクレイピング開始。

- 終了後、「CSV/Excel」で抽出データをダウンロードできます。

Python(Requests+BeautifulSoup)

| メリット | 完全カスタマイズ可能、自由度が最も高い、動的データにも対応できる |

| デメリット | プログラミング知識が必要、サイト構造変更時にメンテナンス必須 |

| こんな方におすすめ | 自社専用ツールを作りたい方、エンジニアリソースがある方 |

| 評価(☆5段階) | 直感的な操作性:★★☆☆☆ 対応できるサイトの幅広さ:★★★★★ データ精度・安定性:★★★★★ 保守・メンテナンス性:★★★☆☆ コストパフォーマンス:★★★★★ |

実際に使ってみた感想

最初はコードを書くことに抵抗がありましたが、思い通りにデータを取れる自由度の高さは圧倒的。

ただ、サイト構成が変わるたびに手直しが必要になるので、保守管理は必須です。

「スクレイピングを自社資産として活用したい」方には強力な武器になるでしょう!

サービスの概要・使い方・特徴を紹介

Pythonでスクレイピングコードを自作することで、目的に完全フィットしたデータ収集が可能になります。

主な特徴は以下の通りです。

・HTMLを解析し、欲しい情報だけ抽出

・サーバー負荷を避けた丁寧なクローリングも可能

・APIがないサイトにも対応可能

具体的な設定手順(5ステップ)

- Python開発環境(Anaconda+VSCode)を準備する

まずAnaconda(Pythonの統合環境)を公式サイト(https://www.anaconda.com )からインストールします。

- コードを書くにはVisual Studio Code(VSCode)がおすすめ。拡張機能「Python」も入れておきます。

- 必要なPythonライブラリ(requests・beautifulsoup4)をインストールする

VSCodeでターミナル(コマンドプロンプト)を開いて、以下を実行します。

pip install requests beautifulsoup4

- 取得したいWebサイトの構造を確認する

Chromeの「検証ツール」(右クリック→検証)を使って、欲しい情報がどのHTMLタグに入っているか調べます。

- Pythonでスクレイピング用コードを書く

例えば次のように書きます。Wikipdiaの「人工知能」ページから概要部分を抽出しています。

import requests

from bs4 import BeautifulSoup

url = 'https://ja.wikipedia.org/wiki/人工知能'

# ページを取得

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 概要部分の最初の段落を抽出

first_paragraph = soup.select_one('div.mw-parser-output > p')

# 出力

if first_paragraph:

print(first_paragraph.get_text(strip=True))

else:

print("概要が見つかりませんでした")欲しいデータを抽出して、リストやCSVに保存できるようにしていきます。

自社で自動化する際によくある失敗ランキング

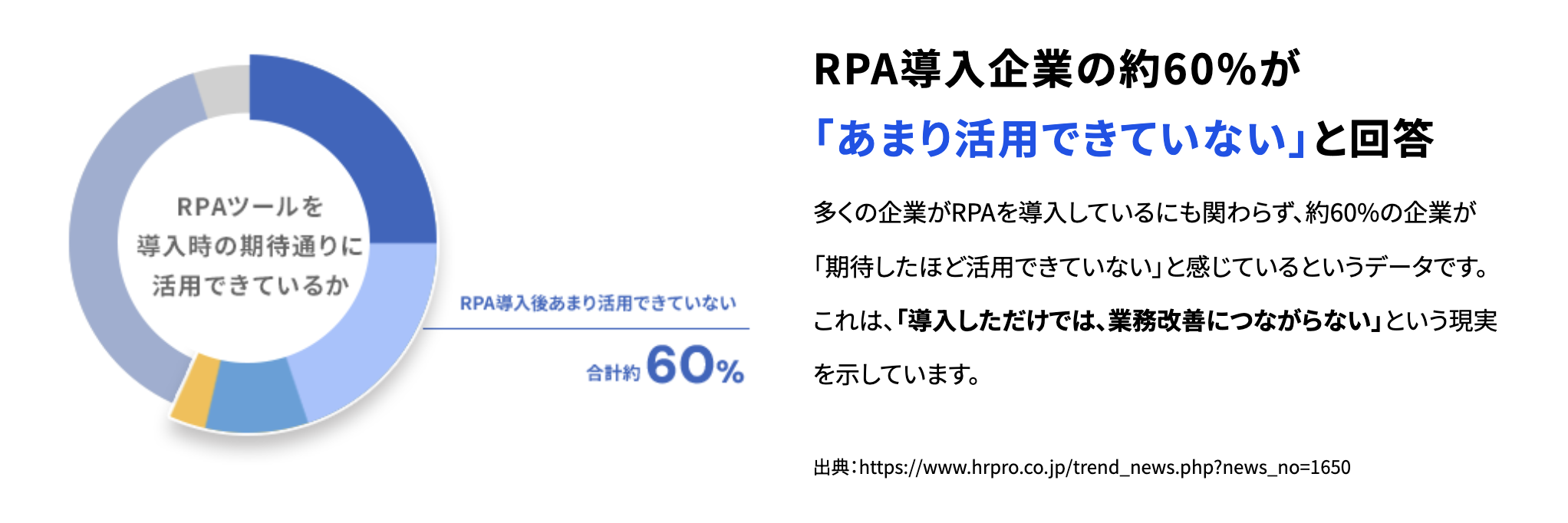

自動化ツールを導入すれば業務が自動化され、効率が劇的に向上する——。

そう考えている企業は多いですが、実際には多くの企業が自動化ツールを十分に活用できていません。

有名な自動化ツールであるRPAを例にあげても、導入した企業の実態は理想と大きく異なった結果となっています。

自動化ツールを導入すれば業務が自動化され、効率が劇的に向上する——。

そう考えている企業は多いですが、実際には多くの企業が自動化ツールを十分に活用できていません。

有名な自動化ツールであるRPAを例にあげても、導入した企業の実態は理想と大きく異なった結果となっています。

RPA導入企業の約60%が「あまり活用できていない」と回答

多くの企業がRPAを導入しているにも関わらず、約60%の企業が「期待したほど活用できていない」と感じているというデータです。これは、「導入しただけでは、業務改善につながらない」という現実を示しています。

多くの企業がRPAを導入しているにも関わらず、約60%の企業が「期待したほど活用できていない」と感じているというデータです。これは、「導入しただけでは、業務改善につながらない」という現実を示しています。

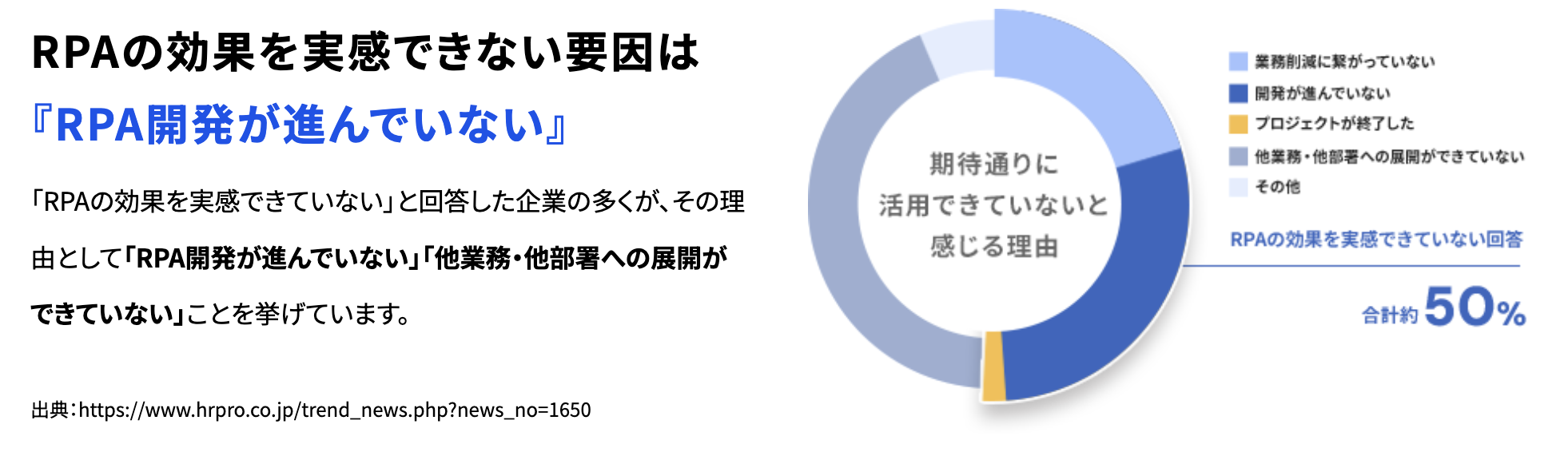

RPAの効果を実感できない要因は『RPA開発が進んでいない』

「RPAの効果を実感できていない」と回答した企業の多くが、その理由として「RPA開発が進んでいない」「他業務・他部署への展開ができていない」ことを挙げています。

「〇〇業務はツールを導入すればすぐにラクになるはず」と思って、自社で自動化に挑戦した方も多いのではないでしょうか?しかし私たちには、こんな“あるあるの失敗談”がよく届きます。

「RPAの効果を実感できていない」と回答した企業の多くが、その理由として「RPA開発が進んでいない」「他業務・他部署への展開ができていない」ことを挙げています。

「〇〇業務はツールを導入すればすぐにラクになるはず」と思って、自社で自動化に挑戦した方も多いのではないでしょうか?しかし私たちには、こんな“あるあるの失敗談”がよく届きます。

🥇 第1位:初期設定でつまずき、結局断念…

思っていたより設定が複雑で、ツールの仕様を理解する前に挫折してしまうケース。 特にRPAツールやノーコードツールは、「慣れるまでが大変」という声が多いです。🥈 第2位:担当者が辞めて、運用不能に…

担当者が社内で唯一のキーマンだった場合、その人がいなくなると全て止まってしまうという問題が発生します。 しかも、「誰も中身が分からないから触れない」という状況になりがち。🥉 第3位:不具合や修正対応に時間がかかる…

自動化が止まったとき、「誰が見ればいいのか分からない」「ベンダーに相談するのも手間」という理由で、対応が後手に。 気づけばその対応に何時間も時間を取られ、本業に集中できなくなってしまうことも…。 実はよくある…自社で自動化に挑戦したときの“落とし穴” 共通するのは「すべて自社で完結しようとした」こと。 このようなケースに共通するのが、「最初から最後まで、すべて自社で完結しようとした」点です。 最初はうまくいっても、長期的に安定した自動化運用には、継続的な保守や柔軟な調整が不可欠です。安定的に自動化したいならジドウカがおすすめ

「ツールを入れただけ」では業務はラクになりません 「業務をラクにする自動化」のためには、設定・運用・トラブル対応まで含めてプロに任せるのが最も確実です。

「ツールを入れただけ」では業務はラクになりません 「業務をラクにする自動化」のためには、設定・運用・トラブル対応まで含めてプロに任せるのが最も確実です。

ジドウカとは?

業務の一部を“タスク単位”で自動化し、月額で安定運用できるサブスクリプション型のサービスです。 技術のことが分からなくても、「こういう作業をラクにしたい」と伝えるだけでOK。ジドウカでできること(業務例)

・定期レポートの自動作成とSlack送信 ・受注データのExcel整形とkintone登録 ・競合サイトの自動モニタリングとアラート通知 ・営業リストの自動生成とCRMへの投入 などジドウカが選ばれる理由

弊社の自動化サービス「ジドウカ」は、1社1社、1タスク1タスクに合わせて完全オーダーメイドで開発するサービス担っています。- ヒアリングから開発・運用まで丸ごとサポート

- トラブル発生時には即時対応

- 月額料金内で自由に修正をご依頼可能

まとめ

手作業による情報収集は時間がかかりミスも起こりやすく、リアルタイム性にも欠けます。こうした課題を解決するのがスクレイピングツールです。

本記事ではノーコードで初心者向けのOctoparse、高機能で動的ページにも対応できるParseHub、自由度が高くエンジニア向けのPython(Requests+BeautifulSoup)の3つを紹介しました。

目的やスキルに応じて最適なツールを選べば、効率的かつ正確にWeb情報を収集できます。